[권신혁의 혁신포커스] “매스웍스, AI 모델 압축 제공…ST·TI·NXP 보드 초소형 신경망 활용 가능”

기사입력 2025.04.08 16:58

▲매트랩 엑스포 2025 코리아에서 발표하는 여동훈 매스웍스코리아 엔지니어

임베디드 AI 위한 검증·네트워크 압축 배포 전략 발표

알고리즘 개발자 AI 모델링·임베디드 협업 효율 제고

비용·성능·메모리 최적화로 AI 모델링 어려움 가중

알고리즘 개발자 AI 모델링·임베디드 협업 효율 제고

비용·성능·메모리 최적화로 AI 모델링 어려움 가중

소형 디바이스에 AI 모델 탑재가 대세로 떠오르는 가운데 AI 제품 개발 과정에서 알고리즘 개발자와 임베디드 S/W 개발자 간 소통과 협업이 훨씬 복잡해지고 지난한 검증 테스트 과정을 반복하게 된다. 매스웍스 이러한 개발 과정을 간소화할 수 있는 솔루션과 데모를 공개해 엔지니어링 시스템의 디지털화를 도모했다.

8일 매스웍스에서 매트랩 엑스포 2025 코리아(MATLAB EXPO 2025 KOREA)를 서울 삼성동 코엑스에서 개최했다. 이번 엑스포에는 1,500여명 이상의 국내외 기술 전문가와 매트랩 및 시뮬링크 고객들이 참석해 최신 엔지니어링 기술과 트렌드를 확인했다.

이날 메인 트랙1에서는 ‘알고리즘 개발 및 AI’를 주제로 세션들이 이어졌다. 여동훈 매스웍스코리아 엔지니어는 ‘임베디드 AI를 위한 검증 및 네트워크 압축을 통한 배포 전략’을 발표해 소형 디바이스 개발에서의 알고리즘 모델링과 임베디드 S/W 개발 과정 간 협업 효율성을 제고하는 전략을 설명했다.

소형 기기의 뉴럴 네트워크 개발을 담당했던 경험을 바탕으로 여동훈 엔지니어는 시스템 요구를 만족하기 위한 검사들이 수동으로 하기에는 매우 업무량이 과중하게 된다는 것을 지적했다.

그는 “모델을 만들 때 몇 천 개를 만들어 콤비네이션을 가하는데 이를 매번 테스트하기 번거롭다”면서, “시스템 요구사항에 대한 체계적인 관리가 필요하다”고 강조했다. 이어지는 임베디드 과정도 복잡해지고, 임베디드 개발팀의 피드백이 다시 알고리즘 개발팀으로 넘어오게 되면서 발생하는 문제들을 매트랩을 통해 해결해 이에 대한 인사이트를 공유했다.

엔지니어링 시스템은 거대하고 복잡한 구조로 인해 통합적으로 테스트할 수 있는 플랫폼이 필요하며, 특히 AI가 도메인 문제를 풀어주는 핵심으로 부상하고 있다. 이는 버츄얼 센서와 같은 것을 예로 들 수 있다.

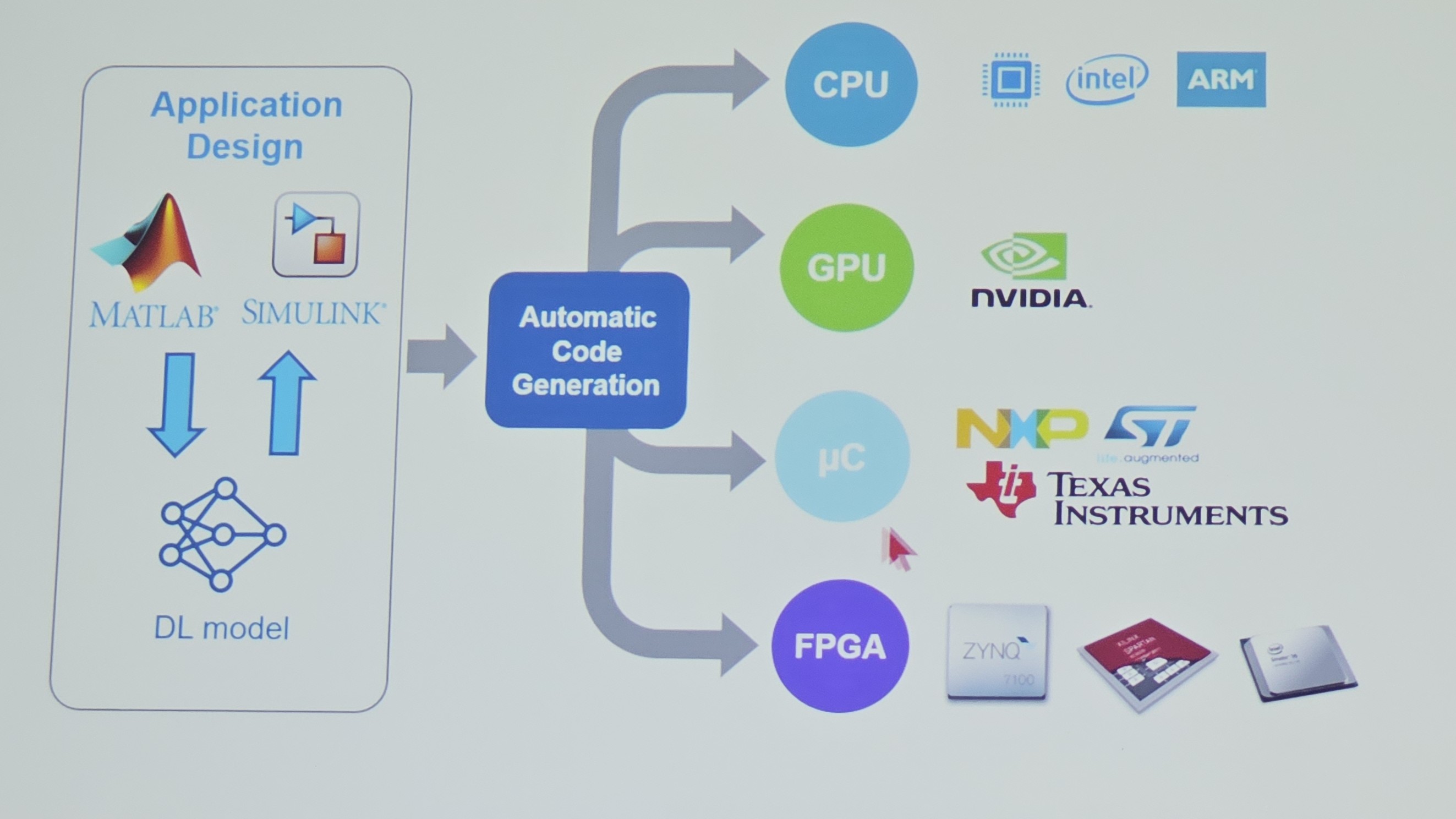

매트랩 솔루션은 뉴럴 네트워크 설계 이후 시뮬레이션을 비롯해 코드 생성, 테스트까지도 모두 디지털화해 시스템 엔지니어링을 지원하고 있다. 특히 임베디드 디바이스는 최대한 저렴한 보드를 채택해 성능과 메모리 용량이 낮은 스펙에서 AI 모델링을 진행해야 하는 개발 난제가 발생할 가능성이 높다.

이에 매스웍스는 AI 모델 압축을 제공하며 양자화 및 투영, 가지치기 등으로 뉴럴 네트워크를 압축해 메모리 사용량을 줄이고 추론 성능은 높이는 솔루션을 지원한다. MCU에서 초소형 신경망 배포 등에 활용 가능하며 ST, TI, NXP 등의 제품을 지원하고 있다.

▲코드 자동 생성을 지원하는 프로세서 종류

여 엔지니어는 “텐서플로우 라이트는 라이브러리를 지원하지 않는 디바이스에는 탑재할 수 없다는 한계점이 있다”면서, “NXP나 STM MCU에서 라이브러리를 쓸 수 없는 경우에도 매트랩은 코드 생성이 가능하다는 것이 가장 큰 특징점이며 PIL 테스트를 위한 여러 디버깅 시스템, 시뮬레이션 등의 여러 기능을 제공한다”고 강조했다.

많이 본 뉴스

[열린보도원칙] 당 매체는 독자와 취재원 등 뉴스이용자의 권리 보장을 위해 반론이나 정정보도, 추후보도를 요청할 수 있는 창구를 열어두고 있음을 알려드립니다.

고충처리인 장은성 070-4699-5321 , news@e4ds.com